Ihr wollt generative KI ohne Datenschutzbedenken und mit deutlich reduziertem CO₂-Fußabdruck nutzen? Kein Problem – wenn ihr bereit seid, Zeit, Energie und potenziell Geld zu investieren.

Klingt gut? Dann schauen wir uns heute gemeinsam einige Möglichkeiten an, mit denen ihr mit der lokalen und offline Nutzung generativer KI beginnen könnt.

Um enttäuschte Erwartungen zu vermeiden, mache ich am besten direkt zu Beginn klar, für wen ich diesen Artikel schreibe:

- Für Fachkräfte der Sozialen Arbeit, oder andere Interessierte, die generative KI nutzen wollen, den kommerziellen Anbietern, ihrer Datenschutzpraktiken und / oder dem Ressourcenverbrauch der cloud-basierten KI-Dienste jedoch kritisch gegenüberstehen.

- Für technisch interessierte Menschen, die sich mit der lokalen Nutzung generativer KI-Werkzeuge befassen wollen und einen schnellen und einfachen Einstieg suchen.

- Für Nerds und Geeks, die sich zwar selbst super in lokaler generativer KI auskennen und diesen Artikel sicher nicht brauchen, die weniger technisch affinen Menschen in ihrem Umfeld aber zu einem verständlichen Einstiegsartikel schicken wollen.

Diese Ausrichtung bedeutet auch, dass ich bei den technischen Themen und Grundlagen nur vereinfachte Erklärungen vermittle und für Details auf andere Artikel verlinke.

Das tue ich einerseits um diesen Artikel gut lesbar, verständlich und anschlussfähig zu halten. Andererseits, weil ich selbst als Sozialarbeit von Haus aus kein Programmierer oder Techniker bin und mein Wissen aus den verlinkten Artikeln und Quellen beziehe.

Wobei das nicht ganz stimmt. Der besseren Nutzbarkeit halber verlinke ich in diesem Artikel primär deutschsprachige Quellen, während ich selbst hauptsächlich aus englischsprachigen Medien und dem guten alten Learning-by-Doing lerne.

Der Artikel soll dir also den Einstieg erleichtern und dir den Weg zeigen, wenn du bestimmte Aspekte selbstständig vertiefen willst. Einen guten Glossar mit den wichtigsten Begriffen rund um generative KI findest du bei Dr. DSGVO.

Alle Hinweise beziehen sich auf die Nutzung generativer KI Werkzeuge lokal auf einem Computer. Server oder die Verteilung auf Cluster oder ähnliches sind nicht Thema.

Mit diesen Hinweisen soll dem Erwartungsmanagement Genüge getan sein. Auf geht’s in den Artikel.

Meine ersten Erfahrungen mit DeepSeek habe ich in der ersten Ausgabe meines Newsletters „Digital braucht sozial“ aufgeschrieben. Hier geht es zur Anmeldung, falls dich das interessiert: Zur Newsletter Anmeldung „Digital braucht sozial“.

Wo finde ich KI-Modelle für die Offline-Nutzung?

Bevor es um Programme für die lokale Nutzung generativer KI geht, müssen zuerst die passenden KI-Modelle verfügbar sein. Meine primäre Anlaufstelle, und das gilt für alle, mit denen ich über dieses Thema bisher gesprochen habe, ist die Plattform huggingface.co.

Die Plattform selbst beschreibt sich so:

„The AI community building the future. The platform where the machine learning community collaborates on models, datasets, and applications.“

Die Hauptzielgruppe des Angebots sind also Menschen, die im Bereich des Machine Learnings arbeiten, forschen oder sich intensiv mit Trainingsdaten von KI Modellen beschäftigen und beispielsweise auch KI-Modelle selbst trainieren.

Auch Unternehmen wie Google, Microsoft oder Meta steuern KI-Modelle bei und stellen diese teilweise unter offenen Lizenzen zur Verfügung.

Harald Frey hat auf seinem YouTube-Kanal „KI Wissen für Einsteiger“ ein gutes Erklärvideo veröffentlicht, das die Oberfläche von huggingface.co gut darstellt.

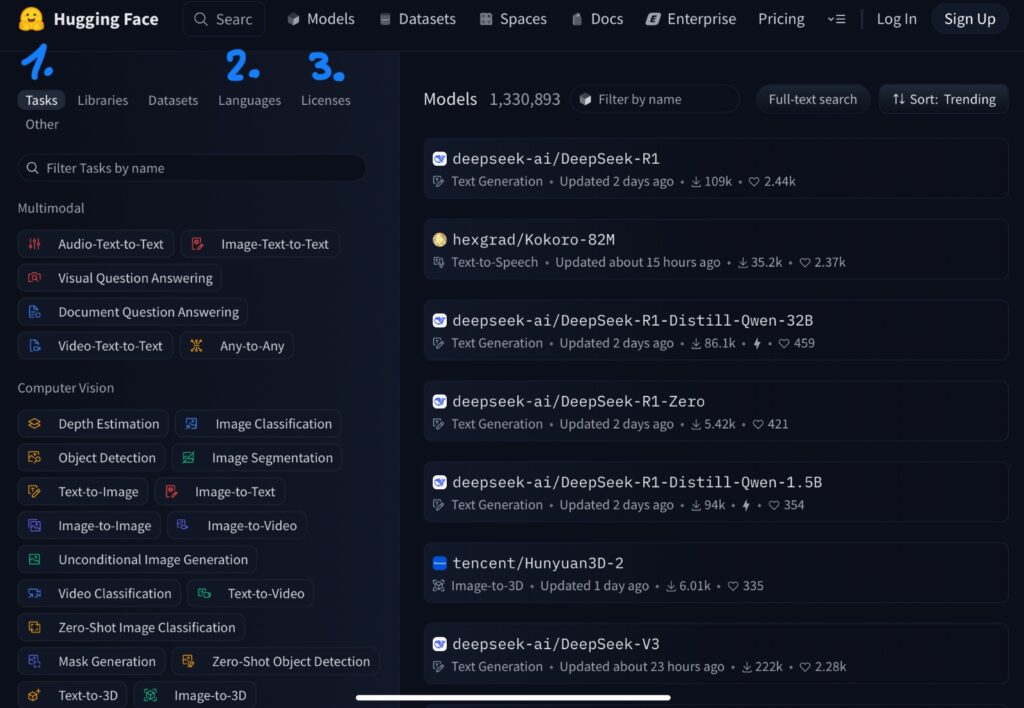

Für die Zwecke dieses Artikels sind der Bereich „Models“ und seine Filterfunktionen relevant.

Im folgenden Screenshot siehst du die drei Bereiche:

- Tasks – Hier kannst du Modelle nach ihrer Funktion und den Aufgaben, für die sie geeignet sind, filtern.

- Language – Hier kannst du die Modelle nach den Sprachen filtern, das betrifft natürlich Sprachmodelle, also LLM (Large Language Models), für die sie trainiert wurden und mit denen sie klarkommen.

- Licenses – Hier werden die Lizenzen der Modelle erklärt. Ich vereinfache stark: Wenn du die Modelle nur privat nutzen und für dich persönlich testen willst, kannst du diesen Filter aus meiner Sicht erstmal ignorieren. Die Lizenz des Modells wird jedoch relevant, wenn du das Modell beispielsweise für einen sozialen Träger oder eine Organisation einsetzen willst. Dann solltest du sicherstellen, dass die kommerzielle Nutzung erlaubt ist.

Die anderen Filter wie Libraries und Datasets sind erst dann interessant für dich, wenn du dich tiefer und intensiver mit den Modellen, ihrem Training und ähnlichen Themen befassen willst.

Du kannst jetzt natürlich auf huggingface Modelle sortieren und Beschreibungstexte lesen. Für den Einstieg empfehle ich dir das auch erstmal, um ein Gefühl für die Modelle zu bekommen. Herunterladen solltest du sie jedoch nicht direkt von der Plattform.

Denn für die konkrete Nutzung können dir die im Folgenden empfohlenen Programme dabei helfen, die passenden KI-Modelle zu finden und herunterzuladen. Das musst du also nicht auf huggingface direkt tun. Welche Modelle sich für mich bewährt haben, erfährst du am Ende des Beitrags, bei den Tipps für den Start.

Eine Sache, bei der dir die Programme auch helfen: einzuschätzen, ob ein KI-Modell auf deinem Computer überhaupt gut funktionieren wird.

Welche Computer-Hardware brauche ich für lokale generative KI?

Die kurze Antwort: Möglichst gute Grafikleistung und möglichst viel Arbeitsspeicher. Wie immer ist die ausführliche Antwort ein wenig komplizierter.

Ich vereinfache hier:

Wenn du einen der neuesten ARM-, Intel- oder AMD-Prozessoren mit einer NPU, das steht für Neural Processing Unit, in deinem Computer hast, brauchst du nicht unbedingt eine dedizierte Grafikkarte. Genug Arbeitsspeicher – 32 GB oder mehr – wären aber auch dann sinnvoll.

Bei den meisten Windows oder Linux Computern würde ich zu einer Grafikkarte und 32, 64 oder mehr GB Arbeitsspeicher raten. Aktuelle Macs, alle mit einem M-Prozessor, kommen auch mit 16 GB mit erstaunlich vielen kleineren Modellen klar. Mehr Arbeitsspeicher ist aber auch hier sinnvoll.

Wenn du es technisch genauer wissen willst, empfehle ich dir den Artikel „So installierst und verwendest du einen KI-Assistenten auf deinem Computer“ von Kasperksy. Wenn du die Werbung für ihre eigene Software ignorieren kannst, bietet er eine gute Einstiegserklärung zu den Eigenarten von KI-Modellen und der nötigen Hardware.

Mit welchen Programmen kann ich generative KI-Modelle lokal nutzen?

Inzwischen gibt es eine Vielzahl von Lösungen für die lokale Nutzung generativer KI-Modelle. Ich gehe im Folgenden nur auf die ein, die ich selbst nutze und daher aus eigener Erfahrung empfehlen kann.

Der einfachste Einstieg ist aus meiner Sicht das Open-Source-Program Jan.ai. Es ist für Windows, Linus und Mac verfügbar.

Die Suchfunktion im Programm greift auf huggingface zurück und zeigt dir beispielsweise an, ob ein Modell auf deinem Computer gut, langsam oder überhaupt nicht laufen wird. Die für den Einstieg empfohlenen KI-Modelle sind für den Start auf jeden Fall ausreichend.

Jan.ai bietet dir als eine gute Möglichkeit, Sprachmodelle lokal auszuprobieren. Allerdings ist die Arbeit mit Dokumenten nicht immer problemlos möglich, und KI-Modelle, die mit Bildern zurechtkommen, habe ich mit Jan.ai noch nicht ans Laufen bekommen.

Wer mehr Möglichkeiten will und bereit ist, sich technisch tiefer einzuarbeiten, kann sich GPT4All und LM Studio anschauen.

Auch diese beiden Programme enthalten eine Suchfunktion für KI-Modelle auf huggingface und zeigen an, wie gut oder schlecht das jeweilige Modell auf dem Computer konkret funktioniert wird. Beide sind für Windows, Linux und Mac verfügbar.

GPT4All macht es einfacher als LM Studio, eigene Dokumente einzubinden und den lokalen KI-Assistenten so mit einer eigenen, individuell zusammenstellbaren Wissensdatenbank zu versorgen. Außerdem ist GPT4All nach eigener Aussage darauf optimiert, auf allgemein verfügbarer Computer-Hardware ohne übertriebene Leistungsansprüche zu funktionieren.

In meinen Tests hat sich das bestätigt, auch wenn es nichts daran ändert, dass größere KI-Modelle schlicht mehr Arbeitsspeicher und Leistung brauchen, um halbwegs anständig zu laufen.

Ich selbst nutze für meine Arbeit primär LM Studio.

Das hat drei Gründe:

- Ich komme besser mit der Oberfläche und dem Verhalten des Programms klar.

- Es bietet mir mehr, wenn auch technisch anspruchsvollere, Möglichkeiten als GPT4All. Dazu gehört beispielsweise die Möglichkeit, einen lokalen LLM Server aufzusetzen und so die in LM Studio verfügbaren Modelle auch mit anderen Programmen auf meinem Mac, beispielsweise mit dem Notizprogramm Obsidian, zu nutzen.

- LM Studio wird meinem Eindruck nach besser und schneller weiterentwickelt als die anderen hier genannten Programme.

Ihr seht: Meine Präferenz für LM Studio ist subjektiv. Mein Tipp für euch: Probiert Jan.ai, GPT4All und LM Studio einige Zeit lang aus und findet für euch heraus, womit ihr am besten klarkommt.

Und bitte lasst euch nicht von Diskussionen auf Reddit oder in Foren von der Software abbringen, die für euch funktioniert. Nur weil Menschen, die ganz andere Anforderungen haben, ein anderes Programm bevorzugen, ist es nicht automatisch besser für euch. Ihr entscheidet, was ihr braucht und nutzt.

Generative Bild- und Audio-KI lokal nutzen

Sowohl im Hinblick auf Bild als auch Audio nutze ich generative KI nur sehr eingeschränkt lokal, deshalb habe ich zu diesem Thema auch nur zwei Tipps für euch:

- Für die Bildgenerierung nutze ich DiffusionBee. Es gibt garantiert bessere lokale Bild-KI-Werkzeuge als dieses, doch da ich es nur für Grafikbriefings und schnelle Visualisierungen nutze, reicht es für mich völlig aus. Wer hier gute Tipps hat: Teilt sie gerne in den Kommentaren. Ein Hinweis: Aktuell ist DiffusionBee nur für macOS verfügbar, für Windows gibt es eine Warteliste.

- In Sachen Audio nutze ich generative KI ausschließlich für offline Transkription von Aufnahmen, die ich aus Gründen des Datenschutzes und der Privatsphäre nicht Cloud-Diensten geben will. Dafür setze ich die in der Grundversion kostenlose Software MacWhisper ein. Für Windows kenne ich leider keine Alternative aus eigener Nutzung. Wer mit einer Cloud-Transkription leben kann, wird bei Happyscribe, seit Jahren meine primäre Transkriptionsplattform, fündig.

Wer für Audio, Bild oder auch Video-KI gute lokale Wege kennt, bitte aus eigener Erfahrung, ist herzlich eingeladen, sie in den Kommentaren zu teilen. Ich probiere gerne neue Möglichkeiten aus.

Gibt es auch andere Wege für lokale generative KI?

Wie eingangs erwähnt, habe ich euch im Artikel nur die Lösungen genannt, die ich selbst nutze und aus eigener Erfahrung empfehlen kann. Dennoch möchte ich auf zwei Programme noch kurz eingehen: Ollama und Pinokio.

Der Pinokio Browser macht es leicht, generative KI-Werkzeuge lokal zu installieren und zu testen, die sonst nur mit größerem technischen Aufwand laufen würden. Zum Ausprobieren ist er eine gute Möglichkeit.

Für die produktive Arbeit kann ich ihn jedoch nicht empfehlen. Dafür sind das Programm und die durch es installierten Werkzeuge zu instabil und zuverlässig.

Deshalb empfehle ich Pinokio auch nicht als Einstiegslösung, sondern eher technisch versierten Menschen, die lokale KI-Werkzeuge testen wollen, bevor sie diese dann selbst, mit höherem technischen Aufwand, installieren.

Für diesen Schritt kommt dann Ollama ins Spiel. Das Programm bietet sehr viele Möglichkeiten, KI-Modelle auch mit anderen Programmen auf dem eigenen Computer zu nutzen. Doch es läuft rein textbasiert, also über Terminal oder Kommandozeile und ist daher meiner Meinung nach nur für technisch affine Nutzerinnen und Nutzer wirklich sinnvoll.

Anders gesagt:

Wenn die Begriffe „Terminal“ oder „Kommandozeile“ bei euch Fragezeichen auslösen und ihr euch die Bedienung eines Programms oder anklickbare Buttons und grafische Oberfläche nicht vorstellen könnt oder wollt, ist Ollama nicht für euch geeignet.

Wofür kann ich generative KI lokal nutzen?

Okay, ihr habt jetzt einen möglichen Einstieg in die lokale Nutzung generativer KI. Doch wozu das Ganze?

Darauf gibt es zahlreiche Antworten. Ich gebe im Folgenden die wieder, die für mich und die Teams in der Sozialen Arbeit, mit denen ich an solchen Dingen arbeiten darf, relevant sind:

- Die Arbeit mit vertraulichen oder aus Datenschutzsicht sensitiven Dokumenten und Daten. Konkret lasse ich mir lange PDF-Dokumente zusammenfassen, vergleiche Varianten und stelle Fragen zu den Dokumenten. Das ersetzt nicht das Lesen des Originals, macht die Erschließung von Informationen jedoch deutlich einfacher.

- Ich lasse meine Konzepte und Strategien, die ich noch nicht veröffentlichen will, von meinem lokalen KI-Assistenten kritisch hinterfragen und analysieren. Natürlich ist nicht jedes Feedback hilfreich und es ersetzt nicht den Austausch mit menschlichen Kolleginnen und Kollegen. Aber es hilft mir dabei, meine Argumente und Konzepte zu optimieren, meine eigenen blinden Flecken zu erkennen und Schwächen zu adressieren, bevor ich mit Menschen darüber spreche.

- Wenn ich bei Texten vor dem leeren Bildschirm und partout keinen Einstieg finde, lasse ich meinen lokalen KI-Assistenten einen Entwurf verfassen. Den nutze ich nicht, aber er ist meist der Impuls, den ich brauche, um meinen eigenen Text in meinem Kopf zu entwickeln. Dann kann ich mit dem Schreiben beginnen.

- Lokale KI-Assistenten können auch beim Brainstorming oder der Ideenfindung zu Themen und Ideen hilfreich sein, die entweder sensibel sind oder mit Daten arbeiten, die nicht in der Cloud landen dürfen oder sollen.

- Wenn ich mich bei meinen rudimentären Programmierkenntnissen unterstützen lassen oder verstehen will, warum mein Code mal wieder nicht funktioniert, hilft ihr mein lokaler KI-Assistent mit dem passenden KI-Modell weiter. Ja, das ginge auch mit ChatGPT, aber für meine Coding-Arbeit wäre mir das schlicht zu viel Ressourcenverbrauch und CO₂-Ausstoß.

- Die Teams, mit denen ich bisher dazu arbeiten durfte, testen lokale generative KI vor allem für die Erstellung von Berichten, Dokumentationen, Konzepten und Anträgen. Sie tun das lokal, weil sie mit Daten arbeiten, die sie keinem kommerziellen KI-Anbieter anvertrauen wollen.

Für das letztgenannte Nutzungsszenario sind KI-Assistenten auf dem eigenen Server, wenn mehrere Personen in einer Organisation ihn nutzen sollen, natürlich besser geeignet als Lösungen auf einzelnen Computern. Dafür gibt es andere Programme, die aber nicht in diesen Artikel gehören.

5 Tipps für den Start

Wenn ihr jetzt Lust auf den Einstieg in lokale generative KI bekommen habt, habe ich abschließend 5 Tipps für euch:

- Sucht euch ein Programm heraus – für den Einstieg ist Jan.ai oft am einfachsten – und ladet euch ein oder zwei KI-Modelle herunter, die in der Suche des Programms empfohlen werden. Ich kann euch aus eigener Erfahrung MODELL 1 oder MODELL 2 für den Start empfehlen.

- Entscheidet euch dann, für welche Anwendungsfälle und Nutzungsszenarien ihr euren lokalen KI-Assistenten testen wollt. Legt einen Zeitraum – ich empfehle mindestens vier Wochen – fest, in dem ihr die lokale KI ganz bewusst regelmäßig nutzt.

- Notiert eure Erfahrungen und prüft nach dem Ende der Testzeit, was gut lief und was besser sein könnte. Nehmt euch dann auch gerne die Zeit, nach KI-Modellen zu schauen, die eure Anforderungen besser erfüllen als eure bisherigen oder ob es eine neue Version eures aktuell verwendeten Modells gibt.

- Prüft genau, für welche Aufgaben ihr mit lokalen Modellen arbeiten wollt und für welche ihr möglicherweise bei cloud-basierten Diensten bleibt oder einsteigt. Nur weil ihr eine lokale KI habt, bedeutet das nicht, dass die beispielsweise für die Generierung von Bildbeschreibungen für Alt-Texte auch geeignet sein muss.

- Dieser letzte Punkt ist vor allem wichtig, wenn ich die Arbeit mit generativer KI, auch lokal, Spaß macht: Bitte reflektiert regelmäßig, wofür ihr generative KI wirklich braucht und welche Aufgaben auch gut ohne machbar sind.

Ich selbst nutze überwiegend die Modelle TheBloke/DiscoLM_German_7b_v1-GGUF (ein auf deutsch trainiertes Modell), second-state/Llava-v1.5-7B-GGUF (ein Modell, dass auch Bilder erkennen und beschreiben kann) und seit kurzem auch lmstudio-community/DeepSeek-R1-Distill-Llama-8B-GGUF (ja, das ist das viel diskutierte chinesische Modell).

Meine ersten Erfahrungen mit DeepSeek habe ich in der ersten Ausgabe meines Newsletters „Digital braucht sozial“ aufgeschrieben. Hier geht es zur Anmeldung, falls dich das interessiert: Zur Newsletter Anmeldung „Digital braucht sozial“.

Lokale generative KI ist aus meiner Sicht sicherlich ressourcenschonender, privatsphärefreundlicher und nachhaltiger im Einsatz, als cloud-basierte Lösungen. Sie können gerade sozialen Einrichtungen und zivilgesellschaftlichen Organisationen dabei helfen, ihre Abhängigkeit von kommerziellen Anbietern zu reduzieren und generative KI verantwortungsvoller einzusetzen.

Ich selbst nutze sie viel und gerne. Genau deshalb ist mir der Hinweis wichtig: Nur weil eine Technologie bestimmte Dinge sehr gut leisten kann, müssen wir sie deshalb nicht automatisch einsetzen.

Wir entscheiden, in welchen Bereichen und für welche Aufgaben Technologie allgemein und generative KI im Speziellen sinnvoll eingesetzt werden soll – und welche Bereiche und Themen wir bewusst den Menschen vorbehalten.

Schreibe einen Kommentar